はじめに

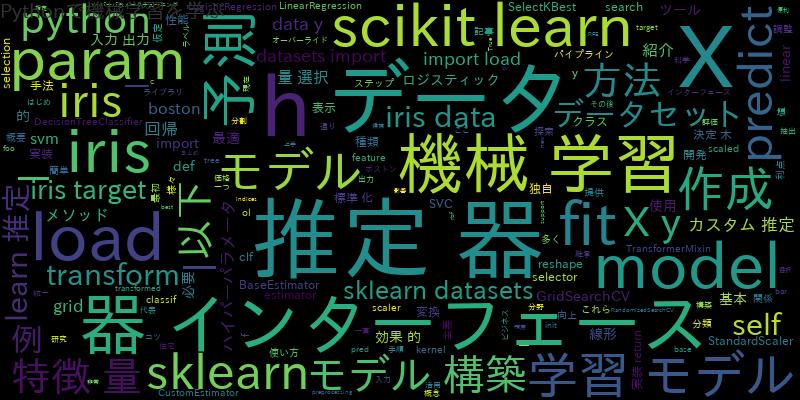

機械学習は現在、ビジネスや科学研究などの様々な分野で活用されています。機械学習を行うためには、データの前処理、特徴量の抽出、モデルの構築、モデルの評価など、多くのステップが必要です。scikit-learnは、Pythonの機械学習ライブラリの一つであり、これらのステップを実装するためのツールを提供しています。

この記事では、scikit-learnの推定器インターフェースを紹介し、機械学習モデル構築におけるコツを紹介します。

scikit-learn推定器インターフェースの概要と利点

scikit-learnの推定器インターフェースは、機械学習モデルを実装するための統一された方法を提供します。このインターフェースを使うことで、様々な種類のモデルを同じ方法で扱うことができます。また、推定器インターフェースを使うことで、機械学習モデルのパイプラインを作成しやすくなります。

推定器インターフェースの利点は以下の通りです。

- 一貫した方法で機械学習モデルを実装できる

- 異なる種類のモデルを同じ方法で扱える

- 機械学習モデルのパイプラインを簡単に構築できる

推定器インターフェースの基本概念:fit、predict、transform

推定器インターフェースは、以下のメソッドを持っています。

- fit(X, y):データセットXとラベルyを使ってモデルを学習する

- transform(X):データセットXを変換する

predict(x):データセットxを使って予測を行う

predict(x):データセットxを使って予測を行う

これらのメソッドを使って、機械学習モデルを構築することができます。以下に、推定器インターフェースの基本的な使い方を紹介します。

from sklearn import svm from sklearn import datasets # データを読み込む iris = datasets.load_iris() X = iris.data[:, :2] # 最初の2つの特徴量を使用 y = iris.target # モデルを作成する clf = svm.SVC(kernel='linear') # モデルを学習する clf.fit(X, y) # 新しいデータを分類する clf.predict([[5.1, 3.5]])

この例では、irisデータセットから最初の2つの特徴量を取り出し、SVMモデルを作成しています。その後、fitメソッドを使ってモデルを学習し、predictメソッドを使って新しいデータを分類しています。

主要なscikit-learn推定器の使用例

scikit-learnには多くの種類の推定器があります。ここでは、代表的な推定器の使用例を紹介します。

線形回帰

線形回帰は、入力と出力の関係が線形であると仮定して、入力から出力を予測する方法です。以下は、線形回帰を使ってボストン住宅価格データセットを予測する例です。

from sklearn.linear_model import LinearRegression from sklearn.datasets import load_boston # データを読み込む boston = load_boston() X = boston.data y = boston.target # モデルを作成する model = LinearRegression() # モデルを学習する model.fit(X, y) # 新しいデータを予測する model.predict(X[0].reshape(1, -1))

ロジスティック回帰

ロジスティック回帰は、入力と出力の関係がロジスティック関数で表されると仮定して、入力から出力を予測する方法です。以下は、ロジスティック回帰を使ってirisデータセットのクラスを予測する例です。

from sklearn.linear_model import LogisticRegression from sklearn.datasets import load_iris # データを読み込む iris = load_iris() X = iris.data y = iris.target # モデルを作成する model = LogisticRegression() # モデルを学習する model.fit(X, y) # 新しいデータを予測する model.predict(X[0].reshape(1, -1))

決定木

決定木は、入力データを分割していくことで、出力を予測する方法です。以下は、決定木を使ってirisデータセットのクラスを予測する例です。

from sklearn.tree import DecisionTreeClassifier from sklearn.datasets import load_iris # データを読み込む iris = load_iris() X = iris.data y = iris.target # モデルを作成する model = DecisionTreeClassifier() # モデルを学習する model.fit(X, y) # 新しいデータを予測する model.predict(X[0].reshape(1, -1))

独自の推定器を作成する方法:カスタム推定器の開発

推定器インターフェースを使って独自の推定器を作成することもできます。以下は、カスタム推定器を開発するための基本的な手順です。

- BaseEstimatorクラスを継承する

- 必要なメソッドをオーバーライドする(fit、predict、transformなど)

以下は、独自の推定器を作成する例です。

from sklearn.base import BaseEstimator, TransformerMixin

from sklearn.datasets import load_iris

class CustomEstimator(BaseEstimator, TransformerMixin):

def __init__(self, param1=1, param2='foo'):

self.param1 = param1

self.param2 = param2

def fit(self, X, y):

# モデルを学習する処理を実装する

return self

def predict(self, X):

# 予測を行う処理を実装する

return y_pred

def transform(self, X):

# データを変換する処理を実装する

return X_transformed

# データを読み込む

iris = load_iris()

X = iris.data

y = iris.target

# カスタム推定器を作成する

estimator = CustomEstimator(param1=2, param2='bar')

# カスタム推定器を学習する

estimator.fit(X, y)

# カスタム推定器を使ってデータを変換する

estimator.transform(X)

scikit-learn推定器インターフェースを使った機械学習モデル構築の効果的な手法

機械学習モデル構築において、推定器インターフェースを使うことで、以下のような効果的な手法があります。

ハイパーパラメータチューニング

モデルの性能を向上させるために、ハイパーパラメータの調整が必要です。scikit-learnでは、GridSearchCVやRandomizedSearchCVといったツールを使って、最適なハイパーパラメータの値を探索することができます。

from sklearn.model_selection import GridSearchCV

from sklearn.svm import SVC

from sklearn.datasets import load_iris

# データを読み込む

iris = load_iris()

X = iris.data

y = iris.target

# SVMモデルを作成する

model = SVC()

# ハイパーパラメータの値の候補を指定する

param_grid = {'C': [0.1, 1, 10], 'kernel': ['linear', 'rbf']}

# GridSearchCVを使って最適なハイパーパラメータを探索する

grid_search = GridSearchCV(model, param_grid=param_grid, cv=5)

grid_search.fit(X, y)

# 最適なハイパーパラメータを表示する

print(grid_search.best_params_)

特徴量の選択

モデルの性能を向上させるために、特徴量の選択が必要な場合があります。scikit-learnでは、SelectKBestやRFEといったツールを使って、最適な特徴量を選択することができます。

from sklearn.feature_selection import SelectKBest from sklearn.feature_selection import f_classif from sklearn.datasets import load_iris # データを読み込む iris = load_iris() X = iris.data y = iris.target # 特徴量の選択を行う selector = SelectKBest(f_classif, k=2) X_new = selector.fit_transform(X, y) # 選択された特徴量を表示する print(selector.get_support(indices=True))

データの前処理

データの前処理は、機械学習モデルの性能に大きな影響を与えます。scikit-learnでは、データの前処理を簡単に行うことができます。例えば、StandardScalerを使ってデータを標準化することができます。

from sklearn.preprocessing import StandardScaler from sklearn.datasets import load_iris # データを読み込む iris = load_iris() X = iris.data y = iris.target # データを標準化する scaler = StandardScaler() X_scaled = scaler.fit_transform(X) # 標準化されたデータを表示する print(X_scaled)

まとめ

scikit-learn推定器インターフェースは、機械学習モデル構築において非常に便利なツールです。推定器インターフェースを使うことで、モデルの構築、ハイパーパラメータの調整、特徴量の選択、データの前処理などを効果的に行うことができます。

この記事では、推定器インターフェースの概要と基本的な使い方、主要なscikit-learn推定器の使用例、カスタム推定器の開発方法、推定器インターフェースを使った機械学習モデル構築の効果的な手法について紹介しました。機械学習モデル構築において推定器インターフェースを上手に使いこなし、高精度なモデルを構築していきましょう。

![[Python]Numpyを使ったRandom Seedの設定 デフォルトとTime](https://machine-learning-skill-up.com/knowledge/wp-content/uploads/2023/12/1-1219.jpg)