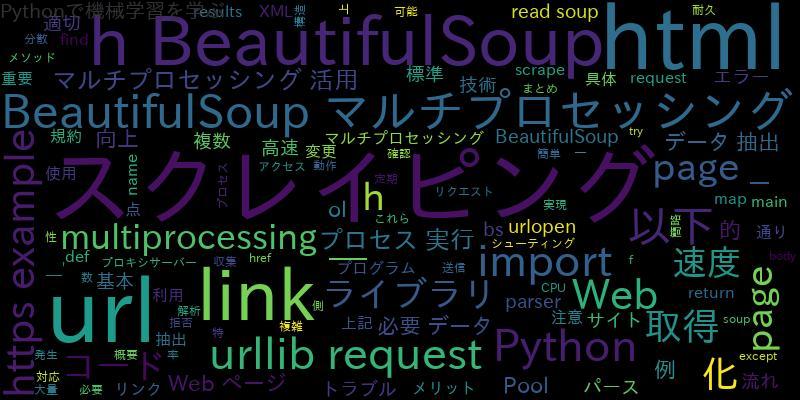

Webスクレイピングは、Web上からデータを収集するための技術です。Pythonには、WebスクレイピングのためのライブラリとしてBeautifulSoupがあります。また、マルチプロセッシングを用いることで、処理の高速化が可能です。

BeautifulSoupとマルチプロセッシングの概要

BeautifulSoupは、HTMLやXMLの解析に特化したPythonのライブラリです。HTMLやXMLをパースして、データを取得することができます。BeautifulSoupは、Pythonの標準ライブラリであるurllib.requestやrequestsと組み合わせて使うことができます。

マルチプロセッシングは、複数のプロセスを同時に実行することで処理速度を高速化するための技術です。Pythonには、multiprocessingという標準ライブラリがあります。multiprocessingを用いることで、複数のプロセスを同時に実行して処理速度を向上させることができます。

BeautifulSoupを用いたスクレイピングの基本

BeautifulSoupを用いたスクレイピングの基本的な流れは、以下の通りです。

- スクレイピングしたいWebページのURLを取得する。

- urllib.requestやrequestsを用いて、WebページのHTMLを取得する。

- BeautifulSoupを用いて、HTMLをパースする。

- 必要なデータを抽出する。

以下に、具体的なコード例を示します。

import urllib.request from bs4 import BeautifulSoup url = 'https://example.com' html = urllib.request.urlopen(url).read() soup = BeautifulSoup(html, 'html.parser') # 必要なデータを抽出する

マルチプロセッシングの基本とそのメリット

マルチプロセッシングは、複数のプロセスを同時に実行することで処理速度を高速化するための技術です。Pythonの標準ライブラリであるmultiprocessingを用いることで、簡単にマルチプロセッシングを実現することができます。

マルチプロセッシングを用いることで、以下のようなメリットがあります。

- 処理速度の向上

- プログラムの簡略化

- 複雑な処理を分散化することで、プログラムの耐久性の向上

BeautifulSoupとマルチプロセッシングを組み合わせたスクレイピングの流れ

BeautifulSoupとマルチプロセッシングを組み合わせたスクレイピングの流れは、以下の通りです。

- スクレイピングしたいWebページのURLを取得する。

- マルチプロセッシングを用いて、WebページのHTMLを取得する。

- BeautifulSoupを用いて、HTMLをパースする。

- 必要なデータを抽出する。

以下に、具体的なコード例を示します。

import requests

from bs4 import BeautifulSoup

from multiprocessing import Pool

urls = ['https://example.com/page1', 'https://example.com/page2', 'https://example.com/page3']

def scrape(url):

response = requests.get(url)

html = response.text

soup = BeautifulSoup(html, 'html.parser')

# 必要なデータを抽出する

if __name__ == '__main__':

with Pool(3) as p:

p.map(scrape, urls)

上記のコードでは、3つのURLからHTMLを取得するために、3つのプロセスを同時に実行しています。プロセス数は、必要に応じて変更することができます。

BeautifulSoupとマルチプロセッシングを活用したスクレイピングの実際の例

以下は、BeautifulSoupとマルチプロセッシングを活用したスクレイピングの実際の例です。

import urllib.request

from bs4 import BeautifulSoup

from multiprocessing import Pool

def get_links(page_url):

try:

html = urllib.request.urlopen(page_url).read()

soup = BeautifulSoup(html, 'html.parser')

links = soup.find_all('a')

return page_url, [link.get('href') for link in links]

except:

return page_url, []

if __name__ == '__main__':

urls = ['https://example.com/page1', 'https://example.com/page2', 'https://example.com/page3']

with Pool(3) as p:

results = p.map(get_links, urls)

for page_url, links in results:

print(f'Links in {page_url}:')

for link in links:

print(link)

print()

上記のコードでは、3つのURLからリンクを抽出するために、3つのプロセスを同時に実行しています。リンクの抽出には、BeautifulSoupのfind_allメソッドを用いています。

注意点とトラブルシューティング

BeautifulSoupとマルチプロセッシングを活用したスクレイピングには、以下のような注意点があります。

- Webサイトの利用規約に従ってスクレイピングを行うこと

- 大量のリクエストを送信しないこと

- プロキシサーバーを使用すること

- コードのエラー処理を適切に行うこと

また、以下のようなトラブルが発生することがあります。

- Webサイト側からのアクセス拒否

- HTMLの構造が変更された場合にスクレイピングができなくなる

- マルチプロセッシングを用いることで、CPU使用率が上がりすぎる場合がある

これらのトラブルに対応するために、エラー処理を適切に行うことや、定期的にスクレイピングの動作確認を行うことが重要です。

まとめ

BeautifulSoupとマルチプロセッシングを活用することで、Webスクレイピングの処理速度を向上させることができます。しかし、Webサイトの利用規約に従ってスクレイピングを行い、適切なエラー処理を行うことが重要です。

![[Python]Dataframe内の文字列をDatetime型に変換し日付だけ取得](https://machine-learning-skill-up.com/knowledge/wp-content/uploads/2023/12/1-1323.jpg)