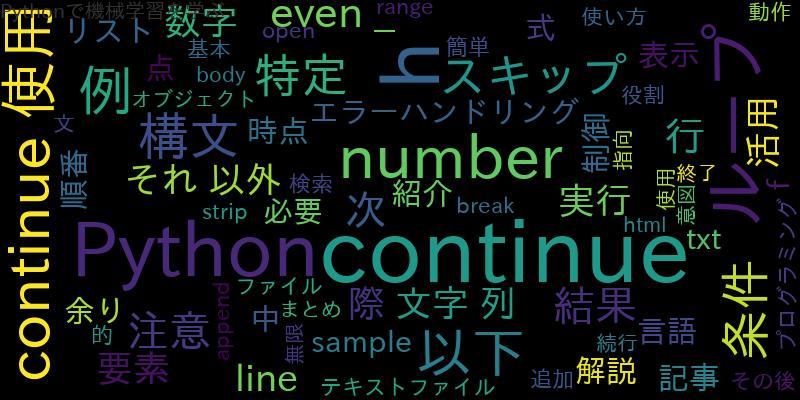

BeautifulSoupとSeleniumの基本的な特性と機能

BeautifulSoupはPythonのライブラリで、HTMLやXMLなどのマークアップ言語からデータを抽出するために使用されます。一方、SeleniumはWebブラウザを自動化するためのツールで、Webページ上での操作やスクレイピングに使用されます。

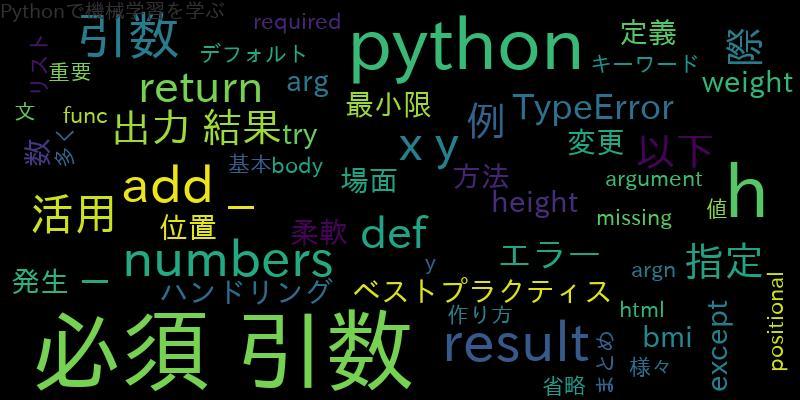

Seleniumを使う理由とその活用方法

Seleniumは、Webページ上での操作やデータの取得において、JavaScriptを含む動的なWebページに対応することができます。また、Webブラウザを自動化することで、自動ログインや自動入力などの処理を実現することができます。

from selenium import webdriver

# Webブラウザを起動

driver = webdriver.Chrome()

# Webページを開く

driver.get("http://example.com")

# ボタンをクリック

button = driver.find_element_by_xpath("//button")

button.click()

# ページソースを取得

page_source = driver.page_source

# Webブラウザを終了

driver.quit()

BeautifulSoupを使う理由とその活用方法

BeautifulSoupは、HTMLやXMLなどのマークアップ言語からデータを抽出するためのライブラリです。Webページ上の特定の要素を取得したり、Webページ内のテキストを抽出することができます。

from bs4 import BeautifulSoup

import requests

# Webページを取得

response = requests.get("http://example.com")

# BeautifulSoupオブジェクトを作成

soup = BeautifulSoup(response.text, "html.parser")

# タイトルタグを取得

title_tag = soup.title

# リンクを取得

link_tags = soup.find_all("a")

# テキストを取得

text = soup.get_text()

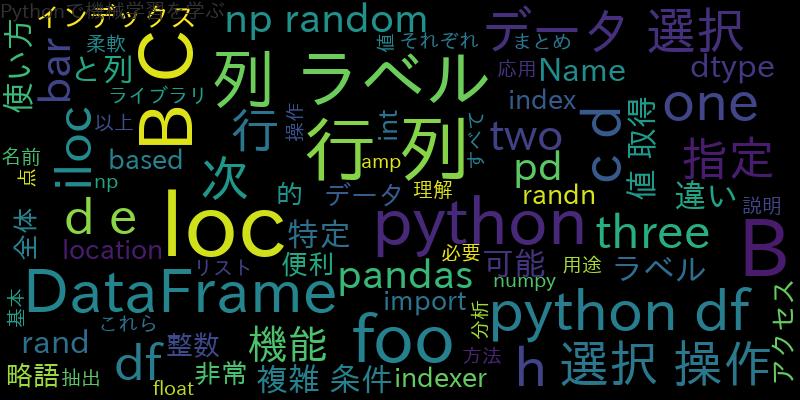

BeautifulSoupとSeleniumを併用するメリット

BeautifulSoupとSeleniumを併用することで、Webページ上の動的な要素やJavaScriptで生成されたデータを取得することができます。また、SeleniumでWebページを自動化して、BeautifulSoupで取得したデータを解析することで、より効率的なスクレイピングが可能になります。

BeautifulSoupとSeleniumの併用方法とその実装例

BeautifulSoupとSeleniumを併用する場合、SeleniumでWebページを開いた後、BeautifulSoupで解析することができます。

from bs4 import BeautifulSoup

from selenium import webdriver

# Webブラウザを起動

driver = webdriver.Chrome()

# Webページを開く

driver.get("http://example.com")

# ページソースを取得

page_source = driver.page_source

# BeautifulSoupオブジェクトを作成

soup = BeautifulSoup(page_source, "html.parser")

# タイトルタグを取得

title_tag = soup.title

# リンクを取得

link_tags = soup.find_all("a")

# テキストを取得

text = soup.get_text()

# Webブラウザを終了

driver.quit()

併用時の注意点とトラブルシューティング

- SeleniumでWebページを開く前に、Webページが完全に読み込まれるまで待機する必要があります。

- Webページ上に表示される動的な要素やデータを取得する場合、Seleniumで操作してからBeautifulSoupで解析する必要があります。

- Webページの構造が変更された場合、スクリプトが動作しなくなることがあります。その場合はスクリプトを修正する必要があります。

まとめ

BeautifulSoupとSeleniumは、それぞれWebスクレイピングにおいて重要な役割を持っています。併用することで、Webページ上の動的な要素やJavaScriptで生成されたデータを取得することができ、より効率的なスクレイピングが可能になります。

![Pandasで空のDataFrameを新規作成、判定する[Python]](https://machine-learning-skill-up.com/knowledge/wp-content/uploads/2023/10/1-38.jpg)