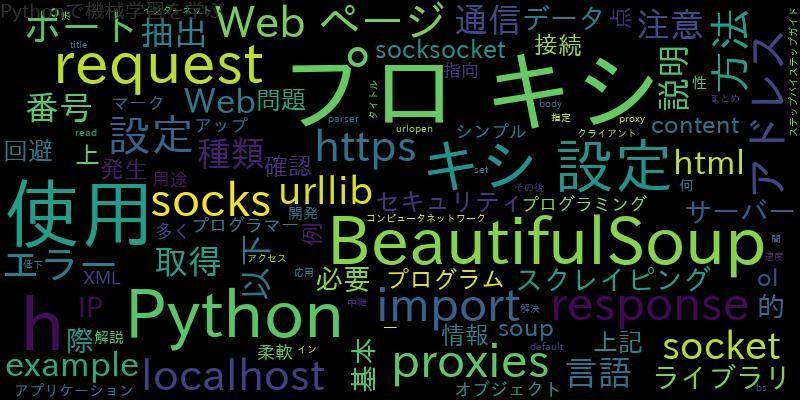

Pythonスクレイピングの基本的な概念とその重要性

Pythonスクレイピングとは、Webサイトから必要な情報を自動的に収集することを指します。この技術を用いることで、大量のWebページから必要な情報を効率的に収集することができます。また、Pythonを使ったスクレイピングは、Webデータを解析することで、ビジネスの意思決定に役立つ情報を収集することができます。

Pythonスクレイピングの基本的な手順とコード例

Pythonスクレイピングの基本的な手順は、以下の通りです。

- 必要な情報を収集するWebページを特定する。

- Pythonを使って、Webページから情報を取得する。

- 取得した情報を解析して必要な情報を抽出する。

以下は、PythonでWebページから情報を取得するコード例です。

import requests url = 'http://example.com' response = requests.get(url) print(response.content)

情報収集自動化の具体的な方法と注意点

Pythonスクレイピングを用いた情報収集自動化の具体的な方法は、以下の通りです。

- 必要な情報を収集するWebページを特定する。

- Pythonを使って、Webページから情報を取得する。

- 取得した情報を解析して必要な情報を抽出する。

- 必要な情報を保存する。

注意点としては、以下のようなものがあります。

- Webページの利用規約に違反しないようにする。

- Webサイトの負荷をかけないようにする。

- 情報の正確性を確認する。

Pythonスクレイピングで情報収集自動化を実現するためのライブラリやツール

Pythonスクレイピングで情報収集自動化を実現するためには、以下のようなライブラリやツールを使用することができます。

- BeautifulSoup

- Scrapy

- Selenium

- Requests-HTML

Pythonスクレイピングを用いた情報収集自動化の実践例

以下は、Pythonスクレイピングを用いた情報収集自動化の実践例です。

import requests

from bs4 import BeautifulSoup

url = 'http://example.com'

response = requests.get(url)

soup = BeautifulSoup(response.content, 'html.parser')

for link in soup.find_all('a'):

print(link.get('href'))

Pythonスクレイピングで情報収集自動化する際のトラブルシューティングと解決策

Pythonスクレイピングで情報収集自動化する際には、以下のようなトラブルが起こることがあります。

- Webページの構造が変更された場合

- Webページの利用規約に違反した場合

- Webサイトからのアクセスが遮断された場合

これらの問題を解決するためには、以下のような対策を取ることができます。

- Webページの構造が変更された場合は、スクレイピングのコードを修正する。

- Webページの利用規約に違反しないようにする。

まとめ

Pythonを使ったスクレイピングで情報収集自動化をすることで、大量のWebページから必要な情報を効率的に収集することができます。また、Pythonスクレイピングを用いることで、ビジネスの意思決定に役立つ情報を収集することができます。しかし、Webページの利用規約に違反することがないように注意する必要があります。