![[Python]PandasとPsycopg2を活用した効率的なBulk Insert方法](https://machine-learning-skill-up.com/knowledge/wp-content/uploads/2023/10/1-66.jpg)

はじめに

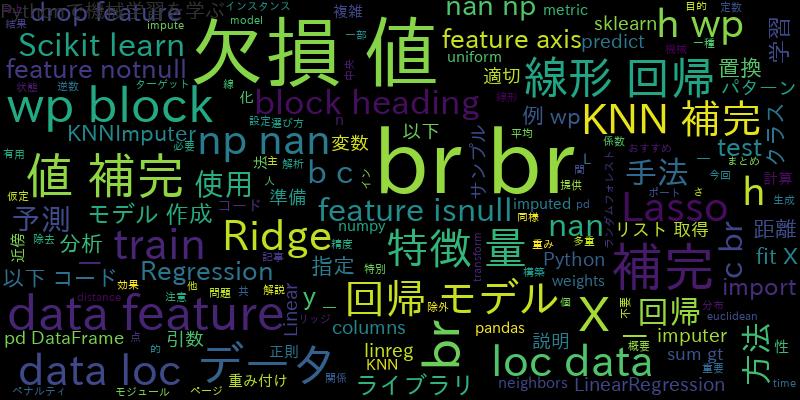

データベースへの大量のデータの挿入は、効率的に行う必要があります。PythonのPandasとPsycopg2を組み合わせて使用することで、効率的なBulk Insertが実現できます。本記事では、PandasとPsycopg2の概要から始め、Bulk Insertの基本概念、必要なライブラリのインストール方法、Pandas DataFrameの準備とデータの整形、Psycopg2を使ったBulk Insertの実装方法、そしてBulk Insertのパフォーマンスチューニングについて解説します。

PandasとPsycopg2の概要とその組み合わせの利点

Pandasは、Pythonでデータ解析やデータ操作を行うための強力なライブラリです。Pandasは高速なデータ操作を可能にし、データを効率的に処理できます。

Psycopg2は、PythonでPostgreSQLデータベースに接続するためのライブラリです。Psycopg2は高いパフォーマンスと安定性を持ち、PostgreSQLデータベースとの連携を容易にします。

PandasとPsycopg2を組み合わせて使用することで、以下のような利点があります。

- PandasのDataFrameを使ってデータを整形し、Psycopg2を使って高速にデータベースに挿入できる。

- Bulk Insertを利用することで、一括でデータを挿入するため、効率的な処理が可能。

- データの整形や前処理をPandasで行いながら、データベースへの挿入も同時に行える。

Bulk Insertの基本概念とその効率性

Bulk Insertとは、データベースへの大量のデータを一度に挿入する方法です。通常の1レコードずつの挿入に比べて、効率的な処理が可能です。

Bulk Insertの効率性は、以下の要素によって向上します。

- データベースへの接続回数を減らすことで、ネットワークのオーバーヘッドを軽減する。

- 一括でデータを挿入することで、データベースへの挿入処理そのもののオーバーヘッドを減らす。

- トランザクションを使用して、データの一貫性と整合性を保つ。

Bulk Insertを使用することで、大量のデータを効率的にデータベースに挿入することができます。次に、必要なライブラリのインストール方法について説明します。

必要なライブラリのインストール方法

PandasとPsycopg2を使用するためには、まずそれぞれのライブラリをインストールする必要があります。

Pandasのインストールには、以下のコマンドを使用します。

pip install pandas

Psycopg2のインストールには、以下のコマンドを使用します。

pip install psycopg2

必要なライブラリのインストールが完了したら、次にPandas DataFrameの準備とデータの整形について解説します。

Pandas DataFrameの準備とデータの整形

Bulk Insertを行うためには、PandasのDataFrameを使ってデータを整形する必要があります。以下の手順でDataFrameを準備し、データを整形します。

- Pandasをインポートします。

- データを読み込み、DataFrameに変換します。

- データの整形や前処理を行います。

例として、以下のようなCSVファイルからデータを読み込み、DataFrameを作成する方法を示します。

import pandas as pd

# CSVファイルからデータを読み込む

data = pd.read_csv('data.csv')

# DataFrameの整形や前処理を行う

...

# DataFrameを表示する

print(data)

上記の例では、’data.csv’というファイルからデータを読み込み、DataFrameを作成しています。データの整形や前処理は、具体的なデータの内容や目的に応じて行います。

次に、Psycopg2を使ったBulk Insertの実装方法について説明します。

Psycopg2を使ったBulk Insert実装方法

Psycopg2を使用してBulk Insertを実装する手順は以下の通りです。

- Psycopg2をインポートし、PostgreSQLデータベースに接続します。

- 接続したデータベース上でテーブルを作成します。

- PandasのDataFrameを使ってデータを整形します。

- DataFrameをSQL文に変換し、一括でデータベースに挿入します。

- 最後に、データベースの接続をクローズします。

以下に、Psycopg2を使ったBulk Insertの実装例を示します。

import pandas as pd

import psycopg2

# PostgreSQLに接続する

conn = psycopg2.connect(host='localhost', port=5432, dbname='mydb', user='myuser', password='mypassword')

cur = conn.cursor()

# テーブルを作成する

cur.execute("CREATE TABLE IF NOT EXISTS mytable (id SERIAL PRIMARY KEY, name VARCHAR(100), age INT)")

# データの整形や前処理を行う

data = pd.read_csv('data.csv')

...

# DataFrameをSQL文に変換し、一括でデータベースに挿入する

values = [str(tuple(x)) for x in data.values.tolist()]

values = ''.join(values)

cols = ','.join(list(data.columns))

query = f"INSERT INTO mytable ({cols}) VALUES {values}"

cur.execute(query)

# コミットして変更を確定する

conn.commit()

# データベースの接続をクローズする

cur.close()

conn.close()

上記の例では、まずPsycopg2を使ってPostgreSQLに接続し、テーブルを作成しています。その後、PandasのDataFrameを使ってデータを整形し、DataFrameをSQL文に変換して一括でデータベースに挿入しています。最後に、変更を確定してデータベースの接続をクローズしています。

Bulk Insertのパフォーマンスチューニング

Bulk Insertのパフォーマンスを最適化するためには、以下のポイントに注意することが重要です。

- データベースとの接続回数を減らすために、トランザクションを使用する。

- 一度に挿入するデータのサイズを調整し、適切なバッチサイズを設定する。

- インデックスや制約の一時的な無効化を検討する。

- 必要な場合にはマルチスレッドや非同期処理を活用する。

これらのチューニングポイントを考慮しながら、Bulk Insertのパフォーマンスを向上させることができます。

まとめ

PythonのPandasとPsycopg2を組み合わせて利用するこれば、効率的なBulk Insertを実現することができます。Pandasを使ってデータの整形や前処理を行いながら、Psycopg2を使って一括でデータベースに挿入することができます。Bulk Insertは大量のデータを効率的に挿入する手法であり、データベースへの接続回数を減らし、データの一貫性を保ちながら処理を高速化することができます。

本記事では、はじめにPandasとPsycopg2の概要とその組み合わせの利点について説明しました。また、Bulk Insertの基本概念と効率性についても触れました。さらに、必要なライブラリのインストール方法やPandas DataFrameの準備とデータの整形方法、Psycopg2を使ったBulk Insertの実装方法について具体的な手順を示しました。最後に、Bulk Insertのパフォーマンスチューニングのポイントについて説明しました。

Bulk Insertを活用することで、大量のデータを効率的にデータベースに挿入することができます。PandasとPsycopg2の組み合わせは、データ処理とデータベース連携の両方の効率化に役立ちます。ぜひこの方法を活用して、効率的なBulk Insertを実現してください。