![PandasのDataFrameがメモリに乗らないときの対処法[Python]](https://machine-learning-skill-up.com/knowledge/wp-content/uploads/2023/10/1-42.jpg)

はじめに

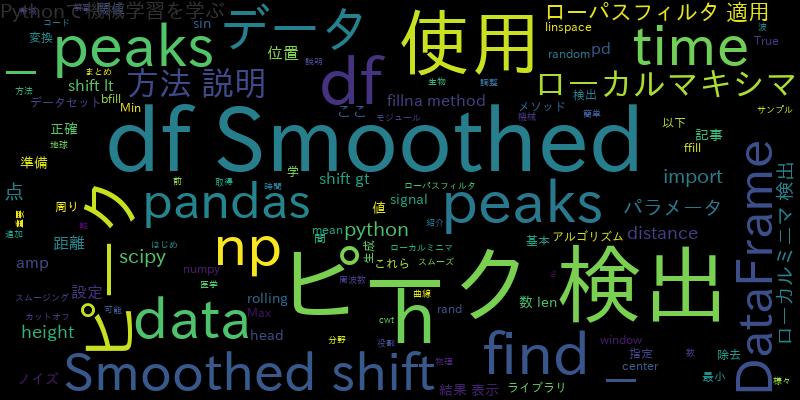

データ分析や機械学習のプロジェクトにおいて、大量のデータを効率的に扱う必要があります。PandasはPythonのデータ分析ライブラリとして広く使われていますが、データサイズが大きくなるとメモリの制約に直面することがあります。この記事では、PandasのDataFrameがメモリに乗らない場合の対処法について紹介します。

Pandas DataFrameのメモリ効率化:データ型の最適化

Pandas DataFrameは、列ごとに異なるデータ型を持つことができます。データ型の選択はメモリ使用量に大きな影響を与えます。データ型を適切に最適化することで、メモリ使用量を削減することができます。

まず、各列のデータ型を確認し、必要に応じて適切なデータ型に変換します。例えば、整数値が格納されている列がある場合、その列のデータ型をint64からint32に変換することで、メモリ使用量を半分に減らすことができます。

import pandas as pd

# DataFrameのデータ型を最適化

df = pd.read_csv('data.csv')

df = df.astype({'column1': 'int32', 'column2': 'float32'})

データ型の最適化は、大きなデータセットのメモリ使用量を大幅に削減するために重要な手法です。

チャンク処理:大きなデータの分割読み込み

メモリに乗らないほど大きなデータセットを扱う場合、一度に全てのデータをメモリに読み込むことはできません。その代わりに、データをチャンク(小さな塊)に分割して読み込むことができます。

Pandasのread_csv関数やread_excel関数などは、チャンク処理をサポートしています。以下の例では、データを10行ずつのチャンクに分割して読み込んでいます。

import pandas as pd

# チャンク処理でデータを読み込む

chunk_size = 10

for chunk in pd.read_csv('data.csv', chunksize=chunk_size):

# チャンクごとに必要な処理を行う

process_chunk(chunk)

チャンク処理を行うことで、メモリ使用量を削減しながら大きなデータセットを効率的に処理することができます。

カテゴリ型の活用:カテゴリカルデータの効率的な取り扱い

カテゴリカルデータは、有限の値を取るデータ型です。例えば、性別やカテゴリごとのラベルなどがカテゴリカルデータの例です。このようなデータを文字列型として扱うと、メモリ使用量が増えてしまいます。

Pandasでは、カテゴリ型という特殊なデータ型を使うことで、カテゴリカルデータのメモリ使用量を削減することができます。

import pandas as pd

# カテゴリ型に変換する

df['category_column'] = df['category_column'].astype('category')

カテゴリ型の活用は、カテゴリカルデータを含むデータセットのメモリ使用量を大幅に削減するための有効な手法です。

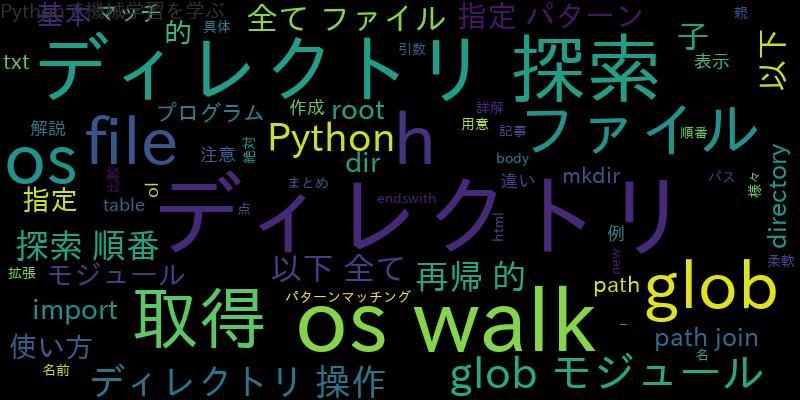

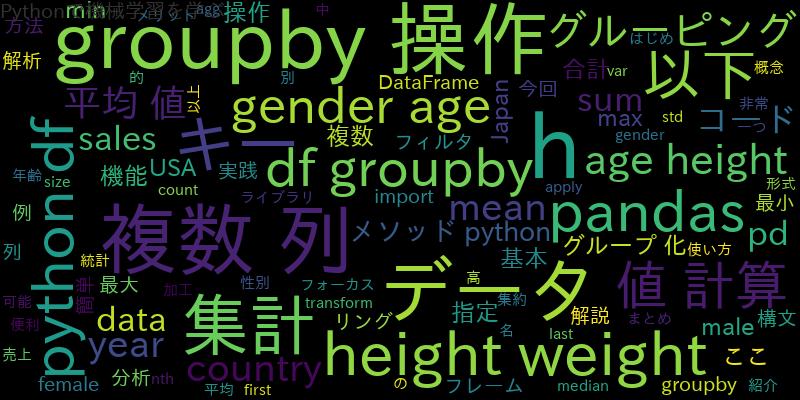

Daskの利用:並列計算ライブラリの活用

Daskは、Pandasの拡張ライブラリであり、大規模なデータセットを分散処理するための機能を提供します。Daskを使用すると、データ処理を複数のタスクに分割し、並列で実行することができます。

以下は、Daskを使用してデータを処理する例です。

import dask.dataframe as dd

# Dask DataFrameを作成

df = dd.read_csv('data.csv')

# Daskを使用してデータ処理を実行

result = df.groupby('column').mean().compute()

Daskを活用することで、メモリに乗らない大きなデータセットを効率的に処理することができます。

行指向フォーマットの利用:ParquetやFeatherの導入

import pandas as pd

# DataFrameをParquet形式で保存

df.to_parquet('data.parquet')

また、ParquetやFeather形式のデータを読み込む際も、メモリ使用量を削減することができます。

import pandas as pd

# Parquet形式のデータを読み込む

df = pd.read_parquet('data.parquet')

行指向フォーマットの利用は、大規模なデータセットの効率的な保存と読み込みにおいて有効な手法です。

Pandas DataFrameをディスクに保存する際、行指向のフォーマットを使用することで、データの圧縮や効率的な読み込みを実現することができます。代表的な行指向フォーマットとして、ParquetやFeatherがあります。ParquetはApache Parquetという高性能なデータストレージ形式であり、データの圧縮や列ごとのデータ型最適化を行うことができます。FeatherはApache Arrowというメモリ内データフォーマットを利用したファイル形式であり、高速な読み書きが可能です。以下は、Pandas DataFrameをParquet形式で保存する例です。

まとめ

この記事では、PandasのDataFrameがメモリに乗らない場合の対処法について紹介しました。以下の手法を活用することで、メモリ使用量を削減し、大きなデータセットを効率的に扱うことができます。

- データ型の最適化

- チャンク処理

- カテゴリ型の活用

- Daskの利用

- 行指向フォーマットの利用

これらの手法を組み合わせて適用することで、メモリに乗らないデータセットでも効率的にデータ処理を行うことができます。データ分析や機械学習のプロジェクトにおいては、これらの対処法を積極的に活用して、スムーズな作業を実現しましょう。