![[Python]スクレイピング !表形式(csv,テーブル)へのデータ抽出](https://machine-learning-skill-up.com/knowledge/wp-content/uploads/2023/12/1-1362.jpg)

こんにちは、Pythonによるスクレイピングについてご紹介します。

Pythonとスクレイピングの基本的な説明

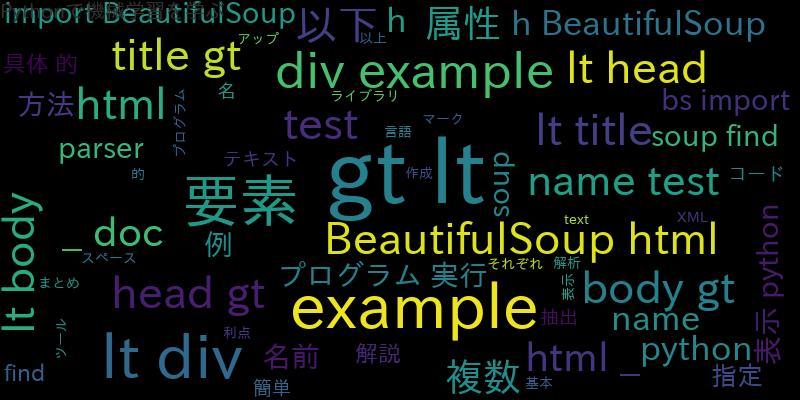

Pythonは、オープンソースのプログラミング言語であり、多くのライブラリが提供されています。その中でも、スクレイピングに関するライブラリが豊富であるため、Webサイトからの情報収集に適しています。

スクレイピングとは、Webサイトから情報を自動的に収集することです。Pythonを使えば、HTMLやXMLなどのマークアップ言語から必要な情報を抽出することができます。

Pythonでのスクレイピングの重要性とその応用例

Pythonでのスクレイピングは、Webサイト上の情報を収集するために非常に重要です。例えば、競合他社のWebサイトから情報を収集することで、自社の商品やサービスの価格や特徴を比較することができます。

また、Webサイトから情報を収集することで、市場調査や顧客分析などのビジネスに役立つ情報を収集することができます。

Pythonでのスクレイピングの基本的な流れ

Pythonでのスクレイピングの基本的な流れは以下の通りです。

- 対象のWebサイトのURLを指定する。

- WebサイトのHTMLを取得する。

- BeautifulSoupを使ってHTMLを解析し、必要な情報を取得する。

- 取得した情報を加工して、必要な形式に整形する。

- 必要に応じてCSV形式で保存する。

表形式のデータ(テーブル)のスクレイピング方法

Webサイト上のテーブルデータは、スクレイピングの対象となることが多いです。Pythonでのテーブルデータのスクレイピング方法をご紹介します。

まずは、以下のようなHTMLのテーブルデータがあるとします。

<table>

<tr>

<td>Alice</td>

<td>20</td>

<td>Female</td>

</tr>

<tr>

<td>Bob</td>

<td>30</td>

<td>Male</td>

</tr>

</table>

このテーブルデータから、以下のようにPythonでデータを取得することができます。

import requests

from bs4 import BeautifulSoup

import csv

url = 'http://example.com/table.html'

res = requests.get(url)

soup = BeautifulSoup(res.text, 'html.parser')

table = soup.find('table')

rows = table.find_all('tr')

csv_data = []

for row in rows:

cols = row.find_all('td')

cols = [col.text.strip() for col in cols]

csv_data.append(cols)

with open('table.csv', 'w', newline='') as f:

writer = csv.writer(f)

writer.writerows(csv_data)

上記のコードでは、BeautifulSoupを使ってHTMLを解析し、テーブル要素を取得しています。次に、テーブルの各行と列を取得して、CSV形式で出力しています。

スクレイピングしたデータをCSV形式で保存する方法

スクレイピングしたデータをCSV形式で保存する方法は、前節でご紹介した通りです。データを取得した後、CSV形式で出力するだけです。

Pythonスクレイピングでの注意点とトラブルシューティング

Pythonでのスクレイピングは、Webサイトの利用規約に違反することがあるため、注意が必要です。また、Webサイトの構造が変わった場合には、スクレイピングができなくなることがあります。

トラブルシューティングのためには、以下のような対応が考えられます。

- スクレイピング対象のWebサイトの利用規約を確認する。

- Webサイトの構造が変わった場合には、スクレイピングの対象を変更する。

- スクレイピングの対象を変更する場合には、対象のWebサイトの利用規約を再度確認する。

まとめ

Pythonを使ったスクレイピングについてご紹介しました。Webサイトから情報を自動的に収集することで、市場調査や顧客分析などのビジネスに役立つ情報を収集することができます。また、テーブルデータのスクレイピング方法やCSV形式での保存方法についてもご紹介しました。

注意点とトラブルシューティングについても理解し、適切にスクレイピングを行ってください。

![[Python]requestsでpost(multipart_form-data response)](https://machine-learning-skill-up.com/knowledge/wp-content/uploads/2023/11/1-314.jpg)